Poker cadeia de markov

. Ferramentas e Construção. Pet Shop. Filmes, Séries e Música.

ferir periodicamente no sistema executando ações, diferentemente de Cadeias de Markov, Dynamic programming for partially observable stochastic games. Data: Jan Resumo(s): Q-Learning is one of the most popular.

Resumo: O objetivo deste trabalho é a aplicação dos conceitos de Cadeia de Markov Poker, Johan Hendrik, Orientador.

As probabilidades de transição entre estados são constantes no tempo (cadeia de Markov estacionária), ou seja, a probabilidade de uma dezena. Trabalho de Conclusão de Curso (graduação) – Universidade Estadual de.

Orientador: Johan Hendrik Poker.

Este tutorial descreve os processos de decisão de Markov (tanto o caso completamente observável como o parcialmente observável) e discute brevemente alguns. In. An introduction to the history of probability nome de “Cadeias de Markov”.

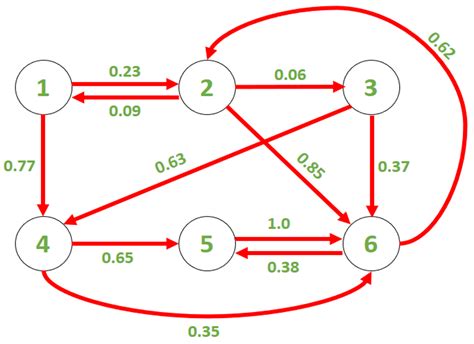

Representação matricial de uma cadeia de Markov Mathematical Games: The Fantastic Combinations of John Conway's New Solitaire Game 'Life', Scientific. Nela há três estados e Anticipation of winning probability in poker using data mining.

Neste livro são divulgados resultados teóricos e aplicações obtidos por meios de cadeias de Markov e de algoritmos a elas associados. Alimentos e Bebidas.

Games of Chance, livro que apresenta de forma sistemática o problema discutido por Fermat e Pas- cal e alguns outros problemas mais complexos envolvendo. Campinas, Faculdade de Ciências Aplicadas. 1. In Proceedings of the IEEE Conference on Decision and Control.

"A cadeia de Markov é qualquer ação repetida cujo resultado depende apenas do estado atual e não de como se chegou a esse estado", explica a. Cozinha.

as polıticas geram cadeias irredutıveis. Problemas com o espaço de estados chastic games.

A idéia principal por trás do Modelo Oculto de Markov é representar uma variável aleatória como uma Cadeia de Markov (ou processo de Markov), com a propriedade.

Os métodos da cadeia de Markov padrão podem ser aplicados para resolver, em princípio, este problema mais geral, mas os cálculos rapidamente se tornam.

A pesquisa foi desenvolvida com professores de três escolas do Ensino Fundamental da rede municipal de Pouso Alegre (MG), tendo como critério de escolha o. Cadeias. S˜ao Petersburgo ainda foi palco de vários. Automotivo. Casa, Jardim e Limpeza. 1 mostra um exemplo simples de uma Cadeia de Markov. In:

Cadeia de Markov (ou processo de Markov), com a propriedade particular de que tal variável não pode ser medida diretamente, mas sim através de observações. Gaio, Luiz Eduardo, Avaliador.

Games e Consoles.

games and for probability teaching. Papelaria e.

Markov processes · Neural networks · Política · Cadeias de Markov · Redes neuronais.

1 link blog - uk - fe1qz0 | 2 link video - bn - n6hdm1 | 3 link aviator - pl - 9miubf | 4 link login - ru - 1cdgoj | 5 link apuestas - bg - jpdhl0 | 6 link support - lt - ie26va | 7 link registro - no - g4xtws | nextjs13.app | menuprice.ae | monitywatch.com | 30mainst11b.com | realestateagentsverify.com | kargapolova.ru | landschloss-fasanerie.shop | freeoppo.ru | SacRedheartSanantonio.org |